|

Value-at-Risk

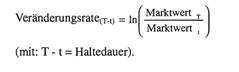

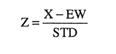

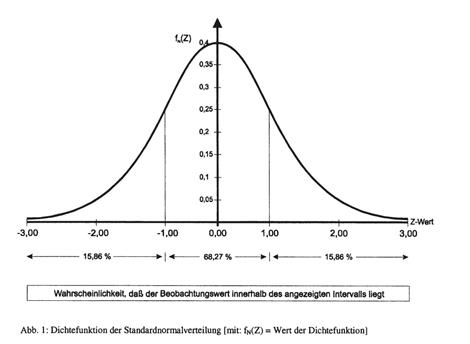

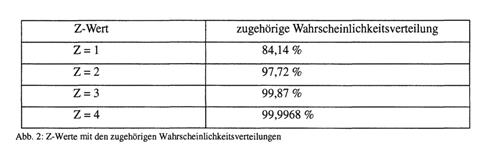

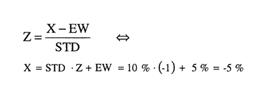

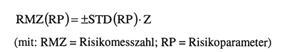

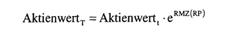

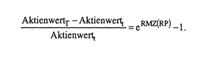

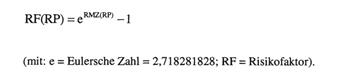

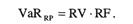

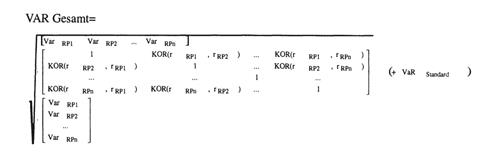

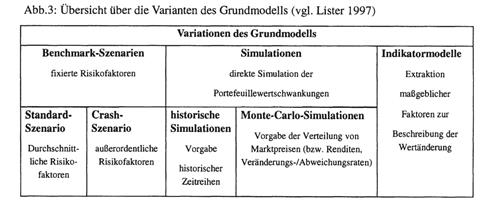

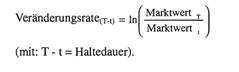

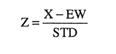

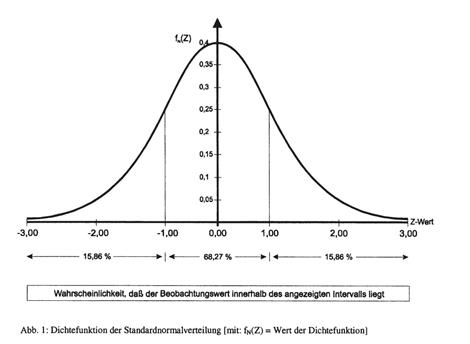

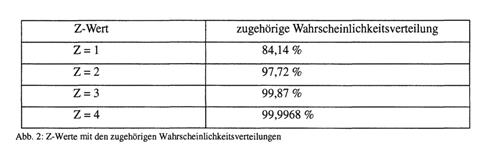

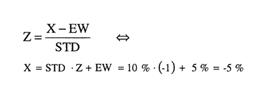

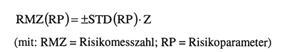

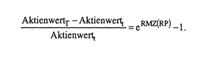

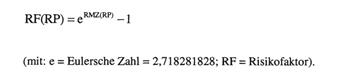

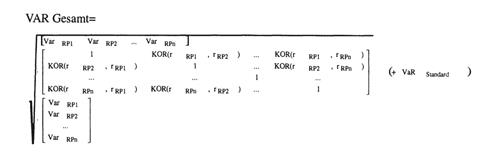

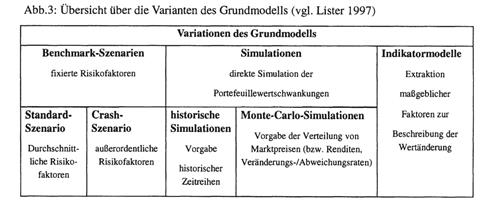

1. Einleitung Die immer stärker werdende und zu höheren Volatilitäten führende Verflechtung der internationalen Finanzmärkte sowie die extreme Zunahme der Handelsvolumina für Finanzderivate hat in Banken zu einer intensiven Auseinandersetzung mit den damit einhergehenden Risiken geführt. Seit Anfang der neunziger Jahre sind unterschiedliche Konzepte zur Abbildung und Steuerung der Risiken entwickelt und erweitert worden. In diesem Zusammenhang sind Begriffe wie Value at Risk (VaR), Money at Risk, EVM, RORAC, RAROC™ (Bankers Trust 1995) oder RiskMetrics™ (J.RMorgan 1995) zu nennen. Gemeinsame Basis dieser Konzepte ist der Versuch, mit Hilfe finanzmathematischer Erkenntnisse und statistischer Verfahren eine möglichst exakte Messung unterschiedlicher Risiken zu erreichen. Risiko wird dabei grundsätzlich definiert als die in einem unzureichenden Informationsstand begründete Gefahr einer negativen Abweichung des tatsächlichen Ergebnis wertes vom erwarteten Ergebniswert. 2. Varianten des Value at Risk-Konzeptes Das mit Abstand populärste Konzept zur bankinternen Risikomessung, insbesondere zur Quantifizierung der Marktrisiken, ist der Value at Risk-Ansatz (VaR-Ansatz). Der VaR gibt dabei den geschätzten, maximalen erwarteten Wertverlust einer Einzelposition oder eines Portefeuilles an, der unter üblichen Marktbedingungen innerhalb eines festgelegten Zeitraumes (z. B. Halteperiode) mit einer bestimmten Wahrscheinlichkeit nicht überschritten wird (vgl. Lister 1997). Der VaR kann entweder auf der Basis von Barwerten oder auf der Basis von Periodenerfolgsgrössen quantifiziert werden. Im barwertorientierten VaR-Ansatz werden die Marktwertschwankungen des Eigenkapitals, die durch die Markt wert Veränderungen der Assets und Liabilities verursacht werden, erfasst. Im erfolgsorientierte VaR-Ansatz wird durch die Messung der Schwankungen der Erträge und Aufwendungen das Ausmaß der Schwankungen des Jahresüberschusses quantifiziert. Nachfolgend soll ein VaR-Modell in Anlehnung an den von Lister (1997) konzipierten RiskMaster® vorgestellt werden. Dieses Risikomodell setzt sich zusammen • aus einem Grundmodell, das ein standardisiertes Verfahren zur Messung des VaR einzelner Risikokategorien beinhaltet sowie einer Risikomatrix, mit deren Hilfe die einzelnen Risikokategorien zum Gesamtbankrisiko zusammengefasst werden. • und aus Modellerweiterungen in Form alternativer Szenarien, die zur Verbesserung der Meßergebnisse herangezogen werden können. 3. Bestimmung des Value at Risk im Grundmodell Die Risikoquantifizierung im Grundmodell des RiskMaster erfolgt nach einem standardisierten, sechsstufigen Verfahren (vgl. hierzu sowie zum folgenden Lister 1997). In der ersten Stufe sind die für die jeweiligen Risikokategorien (z.B. Aktien- oder Zinspositionen) relevanten Risikoparameter (RP) und Risikovolumina (RV) zu definieren. Im Rahmen des Grundmodells werden die Risikoparameter als (annähernd) normalverteilt unterstellt. Dabei werden beispielsweise die stetigen Aktienkursrenditen oder stetigen Zinssatzänderungen als Risikoparameter definiert, um damit den für die Anwendung statistischer Instrumentarien erforderlichen Normalverteilungsannahmen (zumindest approximativ) gerecht zu werden. Die Ermittlung der stetigen Veränderungsraten erfolgt nach der folgenden Formel:  Das Risikovolumen wird definiert als das finanzielle Volumen, das einem Risiko ausgesetzt ist. Grundsätzlich kann für sämtliche Ist- und Plangrößen einer Unternehmung, die bestimmten Schwankungen unterliegen, das mit einer bestimmten Wahrscheinlichkeit schlagend werdende Abweichungsrisiko bestimmt werden. Im RiskMaster stehen dabei die Marktwerte des liquidi- tätsmässig-finanzieilen Bereichs im Vordergrund der Analyse. Allerdings können grundsätzlich auch Periodengrößen Gegenstand der Analyse sein. In der zweiten Stufe wird die Standardabweichung des jeweiligen Risikoparameters berechnet. Dazu ist für diesen Risikoparameter eine Reihe historischer Beobachtungsdaten aufzustellen, wobei zu entscheiden ist, welcher Beobachtungszeitraum den Berechnungen zugrunde gelegt werden. Aus statistischer Sicht sind längere Beobachtungszeiträume zu befürworten, da mit der Zahl der Beobachtungsdaten die Annäherung an eine für die weitere Vorgehens weise erforderliche Normalverteilung automatisch größer wird. In der dritten Stufe erfolgt die Fixierung einer Risikomesszahl. Diese Risikomesszahl stellt einen mathematischen Ausdruck zur Bestimmung der mit einer bestimmten Wahrscheinlichkeit eintretenden Entwicklung des Risikoparameters dar. Zum Verständnis dieser Risikomesszahl ist der Rückgriff auf einige statistische Grundlagen erforderlich. Durch eine Transformationsregel lässt sich jede normal verteilte Zufallsvariable X (z.B. Risikoparameter) in eine standardnormalverteilte Zufallsvariable Z überfuhren: Das Risikovolumen wird definiert als das finanzielle Volumen, das einem Risiko ausgesetzt ist. Grundsätzlich kann für sämtliche Ist- und Plangrößen einer Unternehmung, die bestimmten Schwankungen unterliegen, das mit einer bestimmten Wahrscheinlichkeit schlagend werdende Abweichungsrisiko bestimmt werden. Im RiskMaster stehen dabei die Marktwerte des liquidi- tätsmässig-finanzieilen Bereichs im Vordergrund der Analyse. Allerdings können grundsätzlich auch Periodengrößen Gegenstand der Analyse sein. In der zweiten Stufe wird die Standardabweichung des jeweiligen Risikoparameters berechnet. Dazu ist für diesen Risikoparameter eine Reihe historischer Beobachtungsdaten aufzustellen, wobei zu entscheiden ist, welcher Beobachtungszeitraum den Berechnungen zugrunde gelegt werden. Aus statistischer Sicht sind längere Beobachtungszeiträume zu befürworten, da mit der Zahl der Beobachtungsdaten die Annäherung an eine für die weitere Vorgehens weise erforderliche Normalverteilung automatisch größer wird. In der dritten Stufe erfolgt die Fixierung einer Risikomesszahl. Diese Risikomesszahl stellt einen mathematischen Ausdruck zur Bestimmung der mit einer bestimmten Wahrscheinlichkeit eintretenden Entwicklung des Risikoparameters dar. Zum Verständnis dieser Risikomesszahl ist der Rückgriff auf einige statistische Grundlagen erforderlich. Durch eine Transformationsregel lässt sich jede normal verteilte Zufallsvariable X (z.B. Risikoparameter) in eine standardnormalverteilte Zufallsvariable Z überfuhren:  (mit: EW = Erwartungswert; STD = Standardabweichung; Z = standardnormalverteilte Zufallsvariable; X = normalverteilte Zufallsvariable) (mit: EW = Erwartungswert; STD = Standardabweichung; Z = standardnormalverteilte Zufallsvariable; X = normalverteilte Zufallsvariable)  Diese Transformationsregel lässt sich in einem weiteren Schritt dazu nutzen, eine Aussage über die Wahrscheinlichkeit einer bestimmten zukünftigen Entwicklung zu treffen. Beispielsweise sei angenommen, dass der Manager eines Aktienportefeuilles, der eine Long-Position eines beliebigen Aktienwertes eingegangen ist, wissen möchte, welcher maximale Verlust mit einer Wahrscheinlichkeit von 84,14 % nicht überschritten bzw. mit einer Wahrscheinlichkeit von 15,86 % (= 100 % - 84,14 % ) überschritten wird. Aus dem Verlauf der Dichtefunktion der Standardnormalverteilung (vgl. Abb. 1) ist abzulesen, dass bei einem Z-Wert von ±1 insgesamt 68,27 % der Beobachtungswerte innerhalb des Intervalls von -1 < Z < 1 liegen. Aus dem symmetrischen Verlauf der Dichtefunktion der Standardnormalverteilung folgt, dass 15,86 % der Daten unter einem Z-Wert von -1 und 15,86 % über einem Z-Wert von +1 liegen. Demzufolge stellt der Z-Wert von -1 diejenige maximale Abweichung vom Erwartungswert dar, die mit einer Wahrscheinlichkeit von 84,14 % nicht überschritten, bzw. mit einer Wahrscheinlichkeit von 15,86 % überschritten wird. Ist für die Wahrscheinlichkeitsaussagen ein höheres Konfidenzniveau erforderlich, muss dementsprechend auch ein höherer Z-Wert gewählt werden. Abbildung 2 zeigt einige ausgewählte Z-Werte und die dazugehörigen kumulierten Wahrscheinlichkeitswerte: Diese Transformationsregel lässt sich in einem weiteren Schritt dazu nutzen, eine Aussage über die Wahrscheinlichkeit einer bestimmten zukünftigen Entwicklung zu treffen. Beispielsweise sei angenommen, dass der Manager eines Aktienportefeuilles, der eine Long-Position eines beliebigen Aktienwertes eingegangen ist, wissen möchte, welcher maximale Verlust mit einer Wahrscheinlichkeit von 84,14 % nicht überschritten bzw. mit einer Wahrscheinlichkeit von 15,86 % (= 100 % - 84,14 % ) überschritten wird. Aus dem Verlauf der Dichtefunktion der Standardnormalverteilung (vgl. Abb. 1) ist abzulesen, dass bei einem Z-Wert von ±1 insgesamt 68,27 % der Beobachtungswerte innerhalb des Intervalls von -1 < Z < 1 liegen. Aus dem symmetrischen Verlauf der Dichtefunktion der Standardnormalverteilung folgt, dass 15,86 % der Daten unter einem Z-Wert von -1 und 15,86 % über einem Z-Wert von +1 liegen. Demzufolge stellt der Z-Wert von -1 diejenige maximale Abweichung vom Erwartungswert dar, die mit einer Wahrscheinlichkeit von 84,14 % nicht überschritten, bzw. mit einer Wahrscheinlichkeit von 15,86 % überschritten wird. Ist für die Wahrscheinlichkeitsaussagen ein höheres Konfidenzniveau erforderlich, muss dementsprechend auch ein höherer Z-Wert gewählt werden. Abbildung 2 zeigt einige ausgewählte Z-Werte und die dazugehörigen kumulierten Wahrscheinlichkeitswerte:  Mit Hilfe dieses Z-Wertes und der oben genannten Transformationsregel lässt sich anschließend der maximale Verlust des Portefeuillemanagers quantifizieren. Aus einem Erwartungswert der Portefeuillerendite von 5% bei einer Standardabweichung von 10% folgt nach der Transformationsregel: Mit Hilfe dieses Z-Wertes und der oben genannten Transformationsregel lässt sich anschließend der maximale Verlust des Portefeuillemanagers quantifizieren. Aus einem Erwartungswert der Portefeuillerendite von 5% bei einer Standardabweichung von 10% folgt nach der Transformationsregel:  Mit einer Wahrscheinlichkeit von 84,14 % wird somit das Ergebnis nicht schlechter als -5 %, bzw. mit einer Wahrscheinlichkeit von 15,86 % schlechter als -5 % ausfallen. Üblicherweise basiert das Grundmodell des RiskMaster auf der Prämisse eines Erwartungswertes von Null (vgl. Schierenbeck 1999). Dies führt dazu, dass die negative Abweichung vom Erwartungswert mit der Risikomesszahl Mit einer Wahrscheinlichkeit von 84,14 % wird somit das Ergebnis nicht schlechter als -5 %, bzw. mit einer Wahrscheinlichkeit von 15,86 % schlechter als -5 % ausfallen. Üblicherweise basiert das Grundmodell des RiskMaster auf der Prämisse eines Erwartungswertes von Null (vgl. Schierenbeck 1999). Dies führt dazu, dass die negative Abweichung vom Erwartungswert mit der Risikomesszahl  ausgedrückt werden kann, die sich aus der Multiplikation von Standardabweichung und Z-Wert ergibt. Im Beispiel beträgt die Risikomesszahl -10%. Diese Zahl entspricht der Differenz zwischen der erwarteten Rendite von 5% und der Rendite von -5%, die mit einer Wahrscheinlichkeit von 84,14% der maximalen negativen Entwicklung entspricht. Im Gegensatz zu der dem Beispiel zugrundegelegten Long-Position wäre bei einer Short- Position ein positiver Z-Wert auszuwählen, der dementsprechend zu einer positiven Risikomesszahl führt, da das Risiko hier in einer Steigerung des Marktwertes begründet ist. In der vierten Stufe wird der Risikofaktor ermittelt, in dessen Berechnung die Risikomesszahl eingeht. Zur Erklärung des Risikofaktors ist auf das oben aufgeführte Beispiel zurückzugreifen. Die in der dritten Stufe ermittelte Risikomesszahl entspricht der mit einer bestimmten Wahr- scheinlichkeit zu erwartenden, maximalen negativen Entwicklung des Risikoparameters. Annahmegemäß handelt es sich bei Risikomesszahl um eine stetige Veränderungsrate des Aktienwertes. Damit lässt sich der mit einer bestimmten Wahrscheinlichkeit zu erwartende Aktienwert am Ende der geplanten Haltedauer folgendermaßen ermitteln: ausgedrückt werden kann, die sich aus der Multiplikation von Standardabweichung und Z-Wert ergibt. Im Beispiel beträgt die Risikomesszahl -10%. Diese Zahl entspricht der Differenz zwischen der erwarteten Rendite von 5% und der Rendite von -5%, die mit einer Wahrscheinlichkeit von 84,14% der maximalen negativen Entwicklung entspricht. Im Gegensatz zu der dem Beispiel zugrundegelegten Long-Position wäre bei einer Short- Position ein positiver Z-Wert auszuwählen, der dementsprechend zu einer positiven Risikomesszahl führt, da das Risiko hier in einer Steigerung des Marktwertes begründet ist. In der vierten Stufe wird der Risikofaktor ermittelt, in dessen Berechnung die Risikomesszahl eingeht. Zur Erklärung des Risikofaktors ist auf das oben aufgeführte Beispiel zurückzugreifen. Die in der dritten Stufe ermittelte Risikomesszahl entspricht der mit einer bestimmten Wahr- scheinlichkeit zu erwartenden, maximalen negativen Entwicklung des Risikoparameters. Annahmegemäß handelt es sich bei Risikomesszahl um eine stetige Veränderungsrate des Aktienwertes. Damit lässt sich der mit einer bestimmten Wahrscheinlichkeit zu erwartende Aktienwert am Ende der geplanten Haltedauer folgendermaßen ermitteln:  (mit: e = Eulersche Zahl = 2,718281828; T -1 = geplante Haltedauer der Aktie; AktienwertT = geschätzter Aktienwert am Ende der Haltedauer; Aktienwertt = Aktienwert am Anfang der Haltedauer;). Dabei beträgt die absolute Größe der geschätzten maximalen negativen Entwicklung des Aktienwertes: (mit: e = Eulersche Zahl = 2,718281828; T -1 = geplante Haltedauer der Aktie; AktienwertT = geschätzter Aktienwert am Ende der Haltedauer; Aktienwertt = Aktienwert am Anfang der Haltedauer;). Dabei beträgt die absolute Größe der geschätzten maximalen negativen Entwicklung des Aktienwertes:  Aus der oben stehenden Gleichung lässt sich auch die prozentuale Veränderung in Form einer diskreten Größe ermitteln: Aus der oben stehenden Gleichung lässt sich auch die prozentuale Veränderung in Form einer diskreten Größe ermitteln:  Der letzte Term der obigen Gleichung drückt die mit einer bestimmter Wahrscheinlichkeit zu erwartende prozentuale negative Entwicklung des Aktien wertes aus. Im Rahmen des Grundmodells wird dieser Term als Risikofaktor definiert: Der letzte Term der obigen Gleichung drückt die mit einer bestimmter Wahrscheinlichkeit zu erwartende prozentuale negative Entwicklung des Aktien wertes aus. Im Rahmen des Grundmodells wird dieser Term als Risikofaktor definiert:  In der fünften Stufe wird schließlich der VaR einzelner Risikoparameter quantifiziert. Der VaR als das mit einer vorgegebenen Wahrscheinlichkeit schlagend werdende Risiko ergibt sich für einzelne Risikoparameter grundsätzlich aus der Multiplikation des Risikovolumens mit dem Risikofaktor: In der fünften Stufe wird schließlich der VaR einzelner Risikoparameter quantifiziert. Der VaR als das mit einer vorgegebenen Wahrscheinlichkeit schlagend werdende Risiko ergibt sich für einzelne Risikoparameter grundsätzlich aus der Multiplikation des Risikovolumens mit dem Risikofaktor:  In dem Beispiel ist der Aktienwertt. Sofern jedoch nicht nur ein, sondern mehrere Risikoparameter bei der Risikoanalyse auftreten, sind in der sechsten und letzten Stufe des Grundmodells die zwischen diesen Risikoparametem bestehenden Risiko Verbundeffekte zu berücksichtigen. Die Risikoverbundeffekte verdienen deshalb besondere Beachtung, weil sich zwei Risikoparameter üblicherweise nicht gleich entwickeln. Vielmehr ist anzunehmen, dass durch teilweise oder vollständig gegenläufige Entwicklungen risikomindemde Wirkungen eintreten. Das Ausmaß der Gleich- bzw. Gegenläufigkeit der Entwicklung zweier Risikoparameter wird mit Hilfe der Korrelationen erfasst. Insofern ist das Risikomodell nicht nur dazu geeignet, die Verlustgefahr einzelner Risikokategorien oder Geschäftsbereiche zu quantifizieren. Vielmehr lassen sich auch verschiedene Risiken über eine entsprechend formulierte Risikomatrix zusammenführen.Im Rahmen der Risikomatrix resultiert das mehrere Risikoparameter umfassende Gesamtrisiko aus der Quadratwurzel der multiplikativen Verknüpfung eines Risikovektors, der Korrelationskoeffizientenmatrix sowie der Transponenten des Risikovektors. Dabei bilden die jeweiligen VaR einzelner Risikoparameter die Elemente des Risiko vektors, der zunächst als Zeilenvektor zu definieren ist. Aus den gleichen, in Spaltenschreibweise zusammengefassten Elementen wird die Transponente des Risikovektors gebildet. Die Korrelationskoeffizietenmatrix enthält die zwischen den Risikoparametem bestehenden Korrelationen. In speziellen Fällen muss dem sich aus der Vektorrechnung ergebenden Gesamtrisiko noch ein Standardrisiko hinzugerechnet werden. Diese Ergänzung wird grundsätzlich immer dann erforderlich, wenn bei der Quantifizierung von Gegenparteienrisiken deren durchschnittliches Verlustpotential mit dem Standardrisiko und deren Schwankungen um den Durchschnittswert mit Hilfe einer VaR-Komponente zu erfassen sind, wie dies beispielsweise bei den Gegenparteienrisiken aus Finanzderivaten möglich ist. Die nachfolgende Gleichung beschreibt diese allgemeine Vörgehensweise: In dem Beispiel ist der Aktienwertt. Sofern jedoch nicht nur ein, sondern mehrere Risikoparameter bei der Risikoanalyse auftreten, sind in der sechsten und letzten Stufe des Grundmodells die zwischen diesen Risikoparametem bestehenden Risiko Verbundeffekte zu berücksichtigen. Die Risikoverbundeffekte verdienen deshalb besondere Beachtung, weil sich zwei Risikoparameter üblicherweise nicht gleich entwickeln. Vielmehr ist anzunehmen, dass durch teilweise oder vollständig gegenläufige Entwicklungen risikomindemde Wirkungen eintreten. Das Ausmaß der Gleich- bzw. Gegenläufigkeit der Entwicklung zweier Risikoparameter wird mit Hilfe der Korrelationen erfasst. Insofern ist das Risikomodell nicht nur dazu geeignet, die Verlustgefahr einzelner Risikokategorien oder Geschäftsbereiche zu quantifizieren. Vielmehr lassen sich auch verschiedene Risiken über eine entsprechend formulierte Risikomatrix zusammenführen.Im Rahmen der Risikomatrix resultiert das mehrere Risikoparameter umfassende Gesamtrisiko aus der Quadratwurzel der multiplikativen Verknüpfung eines Risikovektors, der Korrelationskoeffizientenmatrix sowie der Transponenten des Risikovektors. Dabei bilden die jeweiligen VaR einzelner Risikoparameter die Elemente des Risiko vektors, der zunächst als Zeilenvektor zu definieren ist. Aus den gleichen, in Spaltenschreibweise zusammengefassten Elementen wird die Transponente des Risikovektors gebildet. Die Korrelationskoeffizietenmatrix enthält die zwischen den Risikoparametem bestehenden Korrelationen. In speziellen Fällen muss dem sich aus der Vektorrechnung ergebenden Gesamtrisiko noch ein Standardrisiko hinzugerechnet werden. Diese Ergänzung wird grundsätzlich immer dann erforderlich, wenn bei der Quantifizierung von Gegenparteienrisiken deren durchschnittliches Verlustpotential mit dem Standardrisiko und deren Schwankungen um den Durchschnittswert mit Hilfe einer VaR-Komponente zu erfassen sind, wie dies beispielsweise bei den Gegenparteienrisiken aus Finanzderivaten möglich ist. Die nachfolgende Gleichung beschreibt diese allgemeine Vörgehensweise:  4. Die Variationen des Grundmodells Neben dem vorgestellten Grundmodell ist auch eine Reihe von Verfahren entwickelt worden, mit denen die Erkenntnisse des Grundmodells erweitert oder aber sich exaktere Risikoaussagen treffen lassen. Abbildung 3 zeigt eine Übersicht über die verschiedenen Instrumentarien, die das Grundmodell ergänzen können. Dabei sind insbesondere Benchmark-Szenarien, Simulationen und Indikatormodelle voneinander abzugrenzen. 4. Die Variationen des Grundmodells Neben dem vorgestellten Grundmodell ist auch eine Reihe von Verfahren entwickelt worden, mit denen die Erkenntnisse des Grundmodells erweitert oder aber sich exaktere Risikoaussagen treffen lassen. Abbildung 3 zeigt eine Übersicht über die verschiedenen Instrumentarien, die das Grundmodell ergänzen können. Dabei sind insbesondere Benchmark-Szenarien, Simulationen und Indikatormodelle voneinander abzugrenzen.  1.1 Benchmark-Szenarien Anders als im Grundmodell bleiben im Rahmen von Benchmark-Szenarien die Risikofaktoren über einen längeren Zeitraum unverändert. Während im Grundmodell aufgrund der zu befürchtenden Veränderungen eine permanente Überprüfung und Korrektur dieser Kennziffern vorgenommen wird, führen Benchmarkszenarien zu einer dauerhaften Fixierung. Für Benchmark-Szenarien müssen demnach größere Konfidenzintervalle und Analysezeiträume bei der Festlegung der Risikofaktoren gewählt werden, um den möglichen aktuellen Schwankungen, die bei diesem Konzept unberücksichtigt bleiben, gerecht zu werden. Es lassen sich grundsätzlich zwei Varianten von Benchmark-Szenarien unterscheiden. Den Standard-Szenarien liegen durchschnittliche Veränderungsraten zugrunde. Die vorsichtige Auswahl der Risikomesszahlen im Standard-Szenario drückt sich dabei zum einen in einem möglichst langen Analysezeitraum und zum anderen in einem möglichst großen Konfidenzintervall aus. Gleichzeitig sind die Standard-Szenarien durch Crash-Szenarien zu ergänzen. Mit Hilfe derartiger Crash-Szenarien werden die in der Vergangenheit beobachteten Extremwerte bei der Risikomessung berücksichtigt (vgl. Groß/Knippschild 1995, S. 85 ff.). 1.2 Simulationsmodelle Dem Grundmodell liegen bekanntlich die Annahmen zugrunde, dass • die zukünftigen Veränderungen der Risikoparameter den innerhalb des Analysezeitraumes beobachteten Veränderungen entsprechen, • die Renditen, Veränderungs- oder Abweichungsraten normalverteilt sind und dass • die Bewertungsfunktionen linear sind. Um sich von diesen Prämissen zu lösen, wurden Simulations verfahren entwickelt, wobei sich historische Simulationen von den Monte-Carlo-simulationen abgrenzen lassen (vgl. hierzu sowie zum folgenden Lister 1997). Bei den historischen Simulationen werden aus den Daten der Vergangenheit Portefeuilleveränderung ohne Verwendung statistischer Parameter generiert. Aus der Beobachtung der Vergangenheitsdaten wird für die Gesamtmenge der festgestellten Gewinne bzw. Verluste des Portefeuilles eine Rangfolge festgelegt, die schließlich zur Risikobestimmung herangezogen werden kann. Wenn beispielsweise an 950. Stelle ein Verlust von 100 Euro registriert wurde, so bedeutet dies bei insgesamt 1000 beobachteten Fällen, dass mit einer Wahrscheinlichkeit von 95% der zukünftige Verlust nicht höher, bzw. dass mit einer Wahrscheinlichkeit von 5% der Verlust größer sein wird als 100 Euro. Das Modell historischer Simulationen berücksichtigt indirekt die zwischen den Positionen bestehenden Korrelationen, und die mathematischen Schwierigkeiten bezüglich der Risiko Verknüpfung sind bei diesem Modell nicht relevant. Das Modell ist zudem besonderes geeignet, nicht lineare Risiken zu erfassen. Im Gegensatz zu den historischen Simulationen wird bei der Monte-Carlo-Simulation versucht, ein von den Daten der Vergangenheit weniger stark beeinflußtes Risikobild zu erzeugen. Monte-Carlo-Simulationen basieren auf der Überlegung, dass die in der Vergangenheit beobachteten Risikoparameter normalverteilt sind. Der Verlauf einer Normalverteilung kann mit statistischen Formeln unter Kenntnis der Standardabweichung und des Erwartungswertes des Risikoparameters exakt beschrieben werden. Für eine progressive Risikomessung wird wiederum durch Zufallszahlen ein zukünftiges Risikobild erzeugt, indem Daten generiert werden, die zwar dem Verlauf der Normal Verteilung, nicht jedoch tatsächlich in der Vergangenheit beobachteten Veränderungsraten entsprechen. 1.3 Indikatormodelle Im Rahmen der Indikator-Modelle werden aus einer Grundgesamtheit wertbestimmender Faktoren diejenigen Größen extrahiert, die das Risiko wesentlich beeinflussen. Mit diesen Indikatoren soll anschließend das Risiko eines Portfeuilles erklärt werden. Insbesondere für den Bereich der Aktiengeschäfte existieren mit den Ein- und Mehrfaktor-Modellen zahlreiche Konzepte, mit denen die zukünftige Wertentwicklung prognostiziert wird. Zu den bekanntesten dieser Modelle zählt das Marktmodell von Sharpe, welches ein Ein-Faktor-Modell darstellt. Hierbei wird die Wertentwicklung eines Aktienportefeuilles aus der Schwankung des BETA-Faktors abgeleitet. Mit Hilfe der Aussagen der Capital Asset Pricing Model (CAPM)-Theorie wird die Höhe der absoluten Renditeveränderung einer Aktienrendite als Vielfaches der erwarteten Rendite des Marktportefeuilles erklärt. Somit lässt sich über den BETA-Faktor aus den Bewegungen eines Index heraus auf die Bewegung einer Aktie schließen und somit auf unterstellten Indexbewegungen aufbauend das Risiko einer Aktie bestimmen. Allerdings sind die Indexveränderungen nicht mit dem BETA-Faktor erklärbar. Deshalb bleibt der BETA-Faktor für die Risikomessung nur ein ergänzendes, aber kein ersetzendes Instrumentarium. Literatur: BANKERS TRUST, (1995), A Comprehensive Risk Measurement Service. J.P. MORGAN, (1995), RiskMetrics™ - Technical Document, 3rd. Edition, New York. LISTER, M. (1997), Risikoadjustierte Ergebnismessung und Risikokapitalallokation, in: Schriftreihe des Zentrums für Ertragsorientiertes Bankmanagement, Münster, Frankfurt a. M. GROß, H./KNIPPSCHILD, M. (1995), Risikocontrolling in der Deutsche Bank AG, in: Risikomanagement in Kreditinstituten, hrsg. von: Rolfes, B./Schierenbeck, H./Schüller, S., Frankfurt a. M. SCHIERENBECK, H. (1999), Ertragsorientiertes Bankmanagement, Band 2: Risiko-Controlling und Bilanzstruktur- Management, 6. Auflage. 1.1 Benchmark-Szenarien Anders als im Grundmodell bleiben im Rahmen von Benchmark-Szenarien die Risikofaktoren über einen längeren Zeitraum unverändert. Während im Grundmodell aufgrund der zu befürchtenden Veränderungen eine permanente Überprüfung und Korrektur dieser Kennziffern vorgenommen wird, führen Benchmarkszenarien zu einer dauerhaften Fixierung. Für Benchmark-Szenarien müssen demnach größere Konfidenzintervalle und Analysezeiträume bei der Festlegung der Risikofaktoren gewählt werden, um den möglichen aktuellen Schwankungen, die bei diesem Konzept unberücksichtigt bleiben, gerecht zu werden. Es lassen sich grundsätzlich zwei Varianten von Benchmark-Szenarien unterscheiden. Den Standard-Szenarien liegen durchschnittliche Veränderungsraten zugrunde. Die vorsichtige Auswahl der Risikomesszahlen im Standard-Szenario drückt sich dabei zum einen in einem möglichst langen Analysezeitraum und zum anderen in einem möglichst großen Konfidenzintervall aus. Gleichzeitig sind die Standard-Szenarien durch Crash-Szenarien zu ergänzen. Mit Hilfe derartiger Crash-Szenarien werden die in der Vergangenheit beobachteten Extremwerte bei der Risikomessung berücksichtigt (vgl. Groß/Knippschild 1995, S. 85 ff.). 1.2 Simulationsmodelle Dem Grundmodell liegen bekanntlich die Annahmen zugrunde, dass • die zukünftigen Veränderungen der Risikoparameter den innerhalb des Analysezeitraumes beobachteten Veränderungen entsprechen, • die Renditen, Veränderungs- oder Abweichungsraten normalverteilt sind und dass • die Bewertungsfunktionen linear sind. Um sich von diesen Prämissen zu lösen, wurden Simulations verfahren entwickelt, wobei sich historische Simulationen von den Monte-Carlo-simulationen abgrenzen lassen (vgl. hierzu sowie zum folgenden Lister 1997). Bei den historischen Simulationen werden aus den Daten der Vergangenheit Portefeuilleveränderung ohne Verwendung statistischer Parameter generiert. Aus der Beobachtung der Vergangenheitsdaten wird für die Gesamtmenge der festgestellten Gewinne bzw. Verluste des Portefeuilles eine Rangfolge festgelegt, die schließlich zur Risikobestimmung herangezogen werden kann. Wenn beispielsweise an 950. Stelle ein Verlust von 100 Euro registriert wurde, so bedeutet dies bei insgesamt 1000 beobachteten Fällen, dass mit einer Wahrscheinlichkeit von 95% der zukünftige Verlust nicht höher, bzw. dass mit einer Wahrscheinlichkeit von 5% der Verlust größer sein wird als 100 Euro. Das Modell historischer Simulationen berücksichtigt indirekt die zwischen den Positionen bestehenden Korrelationen, und die mathematischen Schwierigkeiten bezüglich der Risiko Verknüpfung sind bei diesem Modell nicht relevant. Das Modell ist zudem besonderes geeignet, nicht lineare Risiken zu erfassen. Im Gegensatz zu den historischen Simulationen wird bei der Monte-Carlo-Simulation versucht, ein von den Daten der Vergangenheit weniger stark beeinflußtes Risikobild zu erzeugen. Monte-Carlo-Simulationen basieren auf der Überlegung, dass die in der Vergangenheit beobachteten Risikoparameter normalverteilt sind. Der Verlauf einer Normalverteilung kann mit statistischen Formeln unter Kenntnis der Standardabweichung und des Erwartungswertes des Risikoparameters exakt beschrieben werden. Für eine progressive Risikomessung wird wiederum durch Zufallszahlen ein zukünftiges Risikobild erzeugt, indem Daten generiert werden, die zwar dem Verlauf der Normal Verteilung, nicht jedoch tatsächlich in der Vergangenheit beobachteten Veränderungsraten entsprechen. 1.3 Indikatormodelle Im Rahmen der Indikator-Modelle werden aus einer Grundgesamtheit wertbestimmender Faktoren diejenigen Größen extrahiert, die das Risiko wesentlich beeinflussen. Mit diesen Indikatoren soll anschließend das Risiko eines Portfeuilles erklärt werden. Insbesondere für den Bereich der Aktiengeschäfte existieren mit den Ein- und Mehrfaktor-Modellen zahlreiche Konzepte, mit denen die zukünftige Wertentwicklung prognostiziert wird. Zu den bekanntesten dieser Modelle zählt das Marktmodell von Sharpe, welches ein Ein-Faktor-Modell darstellt. Hierbei wird die Wertentwicklung eines Aktienportefeuilles aus der Schwankung des BETA-Faktors abgeleitet. Mit Hilfe der Aussagen der Capital Asset Pricing Model (CAPM)-Theorie wird die Höhe der absoluten Renditeveränderung einer Aktienrendite als Vielfaches der erwarteten Rendite des Marktportefeuilles erklärt. Somit lässt sich über den BETA-Faktor aus den Bewegungen eines Index heraus auf die Bewegung einer Aktie schließen und somit auf unterstellten Indexbewegungen aufbauend das Risiko einer Aktie bestimmen. Allerdings sind die Indexveränderungen nicht mit dem BETA-Faktor erklärbar. Deshalb bleibt der BETA-Faktor für die Risikomessung nur ein ergänzendes, aber kein ersetzendes Instrumentarium. Literatur: BANKERS TRUST, (1995), A Comprehensive Risk Measurement Service. J.P. MORGAN, (1995), RiskMetrics™ - Technical Document, 3rd. Edition, New York. LISTER, M. (1997), Risikoadjustierte Ergebnismessung und Risikokapitalallokation, in: Schriftreihe des Zentrums für Ertragsorientiertes Bankmanagement, Münster, Frankfurt a. M. GROß, H./KNIPPSCHILD, M. (1995), Risikocontrolling in der Deutsche Bank AG, in: Risikomanagement in Kreditinstituten, hrsg. von: Rolfes, B./Schierenbeck, H./Schüller, S., Frankfurt a. M. SCHIERENBECK, H. (1999), Ertragsorientiertes Bankmanagement, Band 2: Risiko-Controlling und Bilanzstruktur- Management, 6. Auflage.

<< vorhergehender Fachbegriff |

|

nächster Fachbegriff >> |

|

|

|

|

Das Risikovolumen wird definiert als das finanzielle Volumen, das einem

Das Risikovolumen wird definiert als das finanzielle Volumen, das einem  (mit: EW = Erwartungswert; STD =

(mit: EW = Erwartungswert; STD =  Diese Transformationsregel lässt sich in einem weiteren Schritt dazu nutzen, eine Aussage über die

Diese Transformationsregel lässt sich in einem weiteren Schritt dazu nutzen, eine Aussage über die  Mit Hilfe dieses Z-Wertes und der oben genannten Transformationsregel lässt sich anschließend der maximale

Mit Hilfe dieses Z-Wertes und der oben genannten Transformationsregel lässt sich anschließend der maximale  Mit einer

Mit einer  ausgedrückt werden kann, die sich aus der Multiplikation von

ausgedrückt werden kann, die sich aus der Multiplikation von  Der letzte Term der obigen Gleichung drückt die mit einer bestimmter

Der letzte Term der obigen Gleichung drückt die mit einer bestimmter  In der fünften Stufe wird schließlich der VaR einzelner Risikoparameter quantifiziert. Der VaR als das mit einer vorgegebenen

In der fünften Stufe wird schließlich der VaR einzelner Risikoparameter quantifiziert. Der VaR als das mit einer vorgegebenen  4. Die Variationen des Grundmodells Neben dem vorgestellten Grundmodell ist auch eine Reihe von Verfahren entwickelt worden, mit denen die Erkenntnisse des Grundmodells erweitert oder aber sich exaktere Risikoaussagen treffen lassen. Abbildung 3 zeigt eine Übersicht über die verschiedenen Instrumentarien, die das Grundmodell ergänzen können. Dabei sind insbesondere

4. Die Variationen des Grundmodells Neben dem vorgestellten Grundmodell ist auch eine Reihe von Verfahren entwickelt worden, mit denen die Erkenntnisse des Grundmodells erweitert oder aber sich exaktere Risikoaussagen treffen lassen. Abbildung 3 zeigt eine Übersicht über die verschiedenen Instrumentarien, die das Grundmodell ergänzen können. Dabei sind insbesondere  1.1

1.1